-

Curie: Toward Rigorous and AutomatedScientific Experimentation with AI Agents

Abstract:

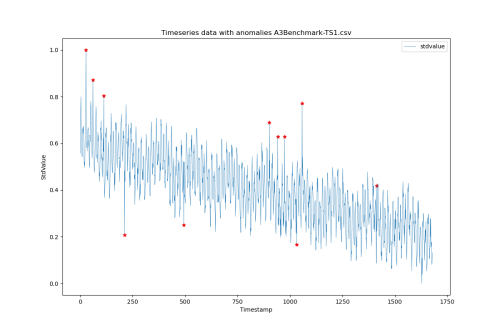

Scientific experimentation, a cornerstone of human progress, demands rigor in reliability, methodical control, and interpretability to yield meaningful results. Despite the growing capabilities of large language models (LLMs) in automating different aspects of the scientific process, automating rigorous experimentation remains a significant challenge. To address this gap, we propose Curie, an AI agent framework designed to embed rigor into the experimentation process through three key components: an intra-agent rigor module to enhance reliability, an inter-agent rigor module to maintain methodical control, and an experiment knowledge module to enhance interpretability. To evaluate Curie, we design a novel experimental benchmark composed of 46 questions across four computer science domains, derived from influential research papers, and widely adopted open-source projects. Compared to the strongest baseline tested, we achieve a 3.4× improvement in correctly answering experimental questions. Curie is open-sourced at https://github.com/Just-Curieous/Curie.

-

诺贝尔传

《诺贝尔传:未竟的梦想》是由瑞典学院院士、诺贝尔文学奖评委英格丽德·卡尔伯格撰写,上海外国语大学瑞典语专业负责人沈贇璐博士翻译的传记作品。以下是具体介绍:

- 内容概述:

- 全面记录生平:将诺贝尔的一生置于宏大的历史背景下,从他在斯德哥尔摩贫苦的童年开始,直至1896年12月10日在圣雷莫去世,追溯了其经历的家族纷争、爱情纠葛、商业纠纷与成功。

- 深入挖掘内心:不仅记录了诺贝尔的科学成就,还通过查阅数千封私人信件等资料,深入挖掘了他的情感世界和个人挣扎,展现了他不为人知的一面,为读者呈现了一个真实立体的诺贝尔形象。

- 揭秘奖项起源:作为首部全面记述诺贝尔及其奖项起源的作品,详细记录了诺贝尔奖从构想到实现的过程,包括诺贝尔的遗嘱、奖金的设立以及各个奖项的评选机制。

- 作品亮点:

- 权威的作者:作者英格丽德·卡尔伯格是资深记者和著名传记作家,有着深厚的学术背景,她的作品往往富有思想深度,对人性有着独到的见解。她历时数年,走访了5个国家的档案馆,搜集了海量的一手资料,确保了内容的真实性和权威性。

- 生动的叙述:书中使用了大量的直接引语和历史档案,增强了叙述的真实感与代入感。采用时间线的方式逐渐铺陈诺贝尔的一生,每一章节都巧妙地连接着诺贝尔科学发明的瞬间与他的内心世界,体现了他对自身成就及其对世界影响的深刻思考,让读者能够清晰地了解诺贝尔的人生轨迹和思想变化。

- 阅读价值:对于历史学家、科学家以及对诺贝尔奖感兴趣的普通读者都具有很高的阅读价值。它不仅提供了关于诺贝尔生平的详实历史资料,揭秘了诺贝尔奖的起源与初心,还启发读者思考个人成就与社会责任之间的关系。瑞典艺术委员会官方评价该书特别揭示了诺贝尔对于科学、文学和和平的深刻关注和远大梦想,反映了诺贝尔奖评选的核心价值和目标,能为现代诺贝尔奖评选提供宝贵的历史背景和深刻的洞见,有助于确保评选过程更加符合诺贝尔的初衷。

- 内容概述:

-

花花草草治愈人心

-

人力资源数字化升级–策略、路径与实践

人力资源数字化升级,2024年人民邮电出版社出版

本书主要探讨人力资源数字化升级的价值、内涵、趋势、策略、路径与实践。从企业管理视角分析了人力资源数字化升级的内外部动因;从应用角度解读了人力资源数字化升级的内涵、构成和价值;从实践角度探讨了如何推动人力资源数字化升级。

本书适合企业管理者、人力资源从业者、人力资源数字化升级研究者、企业咨询顾问,以及对人力资源数字化升级感兴趣的读者阅读参考

-

这就是CHatGPT

Thinking…

《这就是ChatGPT》是一本深入浅出地介绍人工智能语言模型ChatGPT的科普读物,适合对AI技术感兴趣的普通读者和初学者。以下是本书的几个核心亮点及评价:

1. 内容结构清晰,通俗易懂

- 技术解析:从基础原理入手,逐步拆解GPT模型的运作机制,避免了晦涩的数学公式,代之以生活化的类比(如“文字接龙游戏”解释生成逻辑),让读者直观理解AI如何生成文本。

- 发展脉络:梳理了从早期规则系统到深度学习、再到Transformer架构的技术演进,帮助读者建立AI发展的全局视角。

2. 紧扣热点,兼具深度与广度

- 应用场景:详细探讨ChatGPT在写作、编程、教育等领域的实际应用,同时剖析其局限性(如事实性错误、逻辑漏洞),避免技术神话化。

- 伦理讨论:正视AI带来的挑战,包括信息真实性、职业替代、数据隐私等问题,引发读者对技术与人性的辩证思考。

3. 前瞻视角,启发思考

- 未来展望:探讨多模态融合、个性化交互等AI演进方向,同时强调“以人为本”的技术发展观——AI应作为工具扩展人类能力,而非替代人类价值。

- 行动指南:为个人和企业提供适应AI时代的实用建议,如培养批判性思维、聚焦创造力等不可替代的人类特质。

- 技术细节较弱:为照顾可读性,对模型训练细节、参数调整等专业内容着墨较少,技术从业者可能觉得不够深入。

- 案例时效性局限:AI技术迭代极快,书中部分案例在ChatGPT-4等新版模型发布后略显过时,需读者自行延伸阅读。

4. 不足之处

综合评价

- 适合人群:AI初学者、关注技术影响的普通读者、教育工作者及跨领域从业者。

- 阅读价值:★★★★☆(4/5)

本书成功打破了技术壁垒,是一本优秀的AI启蒙读物。尽管存在细节深度和时效性的局限,但其核心价值在于引导读者理性认知AI,既看到潜力也警惕风险,为在智能时代保持清醒提供了重要参考。

延伸建议:

若希望进一步研究技术细节,可结合《深度学习》《自然语言处理入门》等专业书籍;关注伦理与社会影响的读者,推荐《AI 3.0》《人类简史》等著作。 -

THE WORLDS I SEE

《THE WORLDS I SEE》是李飞飞的个人传记,讲述了她从中国到美国的成长经历,以及在人工智能领域的探索、发现与思考。李飞飞以自身经历为线索,展现了人工智能从理论研究到实际应用的发展历程,探讨了该领域在发展过程中面临的机遇与挑战,以及其对社会和人类生活的深远影响。

- 成长背景与早期经历:李飞飞出生于中国,童年在成都度过。父母的性格和教育方式对她影响深远,父亲的好奇心和母亲对知识的热爱,培养了她对世界的探索欲望。在学校,她对数学和科学表现出浓厚兴趣,但也遭遇了性别偏见。1989年,家庭决定移民美国,这一转变给她的生活带来了巨大变化,包括适应新环境、语言障碍和家庭经济困难等问题。

- 学术探索与AI研究起步:在美国,李飞飞努力适应新的学习和生活环境,在高中时期,她得到了数学老师萨贝拉先生的帮助和鼓励,逐渐在学业上取得进步,并被普林斯顿大学录取。在普林斯顿,她主修物理,同时也接触到了计算机科学和神经科学。后来,她在加州理工学院攻读博士学位,期间参与了多个研究项目,包括对猫视觉皮层的实验和“一次性学习”算法的研究,这些经历让她对视觉感知和人工智能有了更深入的理解 。

- ImageNet项目的发起与挑战:受到Biederman的研究启发,李飞飞产生了创建大规模图像数据集ImageNet的想法,旨在为计算机视觉研究提供更丰富的数据支持。在普林斯顿大学任教期间,她与Jia Deng合作开展了ImageNet项目。这个项目面临诸多挑战,如数据收集和标注的困难、资金短缺以及来自学术界的质疑等。但他们通过不断尝试新的方法和技术,如利用众包平台进行数据标注,最终成功创建了ImageNet数据集。

- ImageNet的影响与AI的突破:ImageNet数据集的发布对计算机视觉领域产生了深远影响,引发了一系列关于图像识别和分类的研究。2012年,AlexNet在ImageNet大规模视觉识别挑战赛中脱颖而出,展示了深度学习的强大能力,使神经网络重新成为研究热点。这一突破不仅推动了计算机视觉技术的发展,也引发了人们对人工智能未来发展的更多期待和思考。

- AI在其他领域的应用与探索:李飞飞的研究兴趣不仅局限于计算机视觉,还延伸到了AI在其他领域的应用。她与Arnie Milstein合作,探索AI在医疗保健领域的应用,如开发用于监测医院护理人员手部卫生的技术,以提高医疗质量和患者安全。此外,她还关注AI在社会和伦理方面的问题,如算法偏见、数据隐私等,并积极推动相关的研究和讨论。

- AI的发展与社会影响:随着AI技术的不断发展,其应用范围越来越广泛,对社会产生了深远影响。李飞飞在书中探讨了AI在商业、工业、医疗等领域的应用,以及这些应用带来的机遇和挑战。同时,她也关注到AI发展过程中出现的一些问题,如算法偏见导致的不公平、AI对就业市场的影响以及潜在的伦理风险等。她认为,我们需要在发展AI技术的同时,重视这些问题,并寻找解决办法,以确保AI的发展符合人类的利益。

-

transformer(deepseek)

Thinking…

Transformers are a type of neural network architecture introduced in the paper “Attention Is All You Need” by Vaswani et al. in 2017. They revolutionized NLP tasks. Unlike previous models like RNNs or LSTMs, Transformers use self-attention mechanisms to process all words in a sequence simultaneously, allowing for more parallelization and handling long-range dependencies better.

I should explain the key components: self-attention, multi-head attention, positional encoding, encoder-decoder structure. Also, mention the impact of Transformers on models like BERT, GPT, T5, etc. It’s important to highlight their advantages over RNNs and why they became so popular.

Wait, the user might be looking for both a basic explanation and maybe some details on how they work. Let me structure this logically. Start with an overview, then key components, how they work, advantages, applications, and popular models. That should cover the essentials.

I need to make sure the explanation of self-attention is clear. Maybe use an example, like how each word relates to others in a sentence. Also, touch on positional encoding since Transformers don’t have inherent sequence order understanding like RNNs.

Oh, and the user might be interested in knowing that Transformers are used beyond NLP now, in areas like computer vision with Vision Transformers. Applications are important to mention too—machine translation, text generation, etc.

I should check if there are any common confusions to address. For example, the difference between the Transformer architecture and the models built on it, like BERT vs. the original Transformer. Also, maybe mention the computational aspects, like the need for large datasets and resources.

Make sure the answer is comprehensive but not too technical. Use bullet points for clarity. Alright, time to put it all together in a structured way.

Thinking…Transformers in Deep Learning

Transformers are a groundbreaking neural network architecture introduced in the 2017 paper Attention Is All You Need. They revolutionized natural language processing (NLP) and are now widely used in tasks like translation, text generation, and more. Here’s a breakdown:

Key Components

- Self-Attention Mechanism

- Allows the model to weigh the importance of different words in a sequence relative to each other.

- Example: In “The cat sat on the mat,” the word “cat” relates strongly to “sat” and “mat.”

- Multi-Head Attention

- Runs multiple self-attention operations in parallel, capturing diverse relationships (e.g., syntax, semantics).

- Positional Encoding

- Injects information about word order into the model (since Transformers process sequences in parallel, unlike RNNs).

- Feed-Forward Networks

- Applies non-linear transformations to individual positions after attention.

- Encoder-Decoder Architecture

- Encoder: Processes input and builds contextual representations.

- Decoder: Generates output (e.g., translated text) using encoder outputs and previous decoder states.

How Transformers Work

- Input Embedding: Convert input tokens (words/subwords) into vectors.

- Add Positional Encoding: Embed positional information into vectors.

- Self-Attention Layer: Compute relationships between all tokens.

- Feed-Forward Layer: Refine representations.

- Repeat: Stack multiple layers to capture deeper patterns.

Advantages Over RNNs/CNNs

- Parallelization: Processes entire sequences at once (faster training).

- Long-Range Dependencies: Handles relationships between distant tokens better (no sequential decay).

- Scalability: Efficiently trained on massive datasets (e.g., GPT-3 with 175B parameters).

Applications

- Language Models: GPT, BERT, T5.

- Machine Translation: Google Translate.

- Text Generation: ChatGPT, Claude.

- Vision: Vision Transformers (ViT) for image classification.

- Multimodal Tasks: Models like DALL·E (text-to-image).

Popular Transformer Models

Model Type Use Case BERT Encoder-only Text classification, QA GPT Decoder-only Text generation T5 Encoder-Decoder Text-to-text tasks ViT Vision Image classification

Challenges

- Computational Cost: Requires massive compute/resources (e.g., GPT-4).

- Context Length: Limited by attention’s quadratic complexity (fixed in variants like Flash Attention).

Transformers have become the backbone of modern AI, pushing the boundaries of what’s possible in NLP, vision, and beyond. Let me know if you’d like a deeper dive into any aspect! 🤖

-

卷积神经网络(DeepSeeK)

Thinking…

卷积神经网络(Convolutional Neural Network,CNN)是一种深度学习模型,专门用于处理具有网格结构的数据(如图像、视频、音频等)。其核心思想是通过局部感知、权重共享和空间下采样来自动提取数据中的层次化特征。

以下是卷积神经网络的核心组件和工作原理:

1. 核心组件(1) 卷积层(Convolutional Layer)

- 功能:通过卷积核(滤波器)扫描输入数据,提取局部特征(如边缘、纹理等)。

- 操作:

- 输入数据(如RGB图像)与卷积核进行滑动窗口点乘。

- 输出特征图(Feature Map),反映输入中特定模式的存在位置。

- 参数:

- 卷积核大小(如3×3)、步长(Stride)、填充(Padding)。

(2) 激活函数(Activation Function)

- 作用:引入非线性,增强模型表达能力。

- 常用函数:ReLU(Rectified Linear Unit)、Sigmoid、Leaky ReLU。

(3) 池化层(Pooling Layer)

- 功能:降低特征图的空间维度,减少计算量并增强模型鲁棒性。

- 操作:

- 最大值池化(Max Pooling):取局部区域最大值。

- 平均值池化(Average Pooling):取局部区域平均值。

(4) 全连接层(Fully Connected Layer)

- 功能:将提取的特征映射到最终输出(如分类结果)。

- 特点:每个神经元与前一层的所有神经元连接。

2. 经典CNN架构

(1) LeNet-5

- 提出者:Yann LeCun(1998)。

- 应用:手写数字识别(MNIST)。

- 结构:卷积层 → 池化层 → 卷积层 → 池化层 → 全连接层。

(2) AlexNet

- 里程碑:2012年ImageNet竞赛冠军,开启了深度学习热潮。

- 改进:

- 使用ReLU激活函数加速训练。

- 引入Dropout防止过拟合。

- 多GPU并行训练。

(3) VGGNet

- 特点:通过堆叠小卷积核(3×3)代替大卷积核,减少参数并增强非线性。

(4) ResNet

- 创新:残差学习(Residual Learning),通过跳跃连接(Skip Connection)解决深层网络梯度消失问题。

- 效果:可训练超过1000层的网络。

3. CNN的优势

- 自动特征提取:无需手动设计特征,适合处理高维数据。

- 平移不变性:通过卷积和池化操作,对输入的小幅位移具有鲁棒性。

- 参数共享:同一卷积核在输入的不同位置重复使用,减少参数量。

4. 应用场景

- 图像分类(如识别猫狗)。

- 目标检测(如YOLO、Faster R-CNN)。

- 语义分割(如U-Net)。

- 图像生成(如生成对抗网络GAN)。

- 自然语言处理(如文本分类)。

5. 代码示例(PyTorch)

import torch import torch.nn as nn class SimpleCNN(nn.Module): def __init__(self): super(SimpleCNN, self).__init__() self.conv1 = nn.Conv2d(3, 16, 3) # 输入通道3,输出通道16,卷积核3×3 self.pool = nn.MaxPool2d(2, 2) # 池化层2×2 self.fc = nn.Linear(16*16*16, 10) # 全连接层(假设输入图像为32×32) def forward(self, x): x = self.pool(nn.functional.relu(self.conv1(x))) # 卷积 → ReLU → 池化 x = x.view(-1, 16*16*16) # 展平特征图 x = self.fc(x) return x model = SimpleCNN()6. 挑战与改进

- 过拟合:通过数据增强、Dropout、正则化缓解。

- 计算资源需求:使用轻量化模型(如MobileNet、ShuffleNet)。

- 可解释性:通过类激活图(CAM)、梯度可视化等方法分析模型决策。

卷积神经网络是计算机视觉领域的基石,理解其原理和实现方式是掌握深度学习的关键!

-

Native Sparse Attention Hardware-Aligned and NativelyTrainable Sparse Attention

-

20万张GPU!号称“地球上最聪明的AI”Grok-3来了,斩获多个Top1

北京时间 2 月 18 日中午,埃隆·马斯克旗下的人工智能公司 xAI 重磅发布了 Grok 3 系列模型,宣称其在数学、科学和编码基准测试中,击败了 Google Gemini、DeepSeek V3、Claude 以及 OpenAI 的 GPT-4o。

更为值得关注的是,Grok 3 的训练并非如此前传闻的在“10 万张 GPU 上进行”,而是使用了“20 万张 GPU”。对此,有网友指出其算力消耗是 DeepSeek V3 的 263 倍。正因此,“又壕又横”的马斯克将其称为“地球上最聪明的 AI”。

Grok 3 基准测试曝光根据 xAI 工程师的介绍,Grok 3 其实是一个模型家族——而不仅仅是一个模型。Grok 3 的轻量级版本——Grok 3 mini——在牺牲一定准确度的情况下,能够更快地响应问题。

目前,并不是所有模型都已经上线(其中一些仍处于测试阶段),但会从今天开始陆续推出。此外,原定今天要发布的语音模式并未出现,马斯克随后也在 X 上解释称,“语言模式仍然有点不完善,所以大概会在一周左右推出,但它很棒。”

根据官方公开的测试结果,Grok 3 在包括 AIME(评估模型在一系列数学问题上的表现)和 GPQA(评估模型在博士级别的物理学、生物学和化学问题上的表现)等基准测试中,远超 GPT-4o、Gemini-2 Pro、DeepSeek V3、Claude 3.5 Sonnet 等大模型。

在大模型竞技场 Chatbot Arena(LMSYS)测试中,xAI 工程师表示,早期版本的 Grok-3 获得了第一的成绩,达到了 1402 分,超越了 Gemini 2.0 Flash Thinking 实验版本、ChatGPT-4o 最新版本以及最近大火的 DeepSeek R1 等等。要知道在 Chatbot Arena 中,用户或评审可以通过对比不同的模型响应,并进行投票,以评定哪个模型提供了最佳的答案。平台通过这种“人类评分”的方式帮助研究人员和开发者了解各大聊天机器人模型的优劣,推动模型的持续改进。时下 Grok 3 是在过往业界已发布的大模型中首个突破 1400 分、获得多个第一的大模型。