机器学习算法

机器学习算法

-

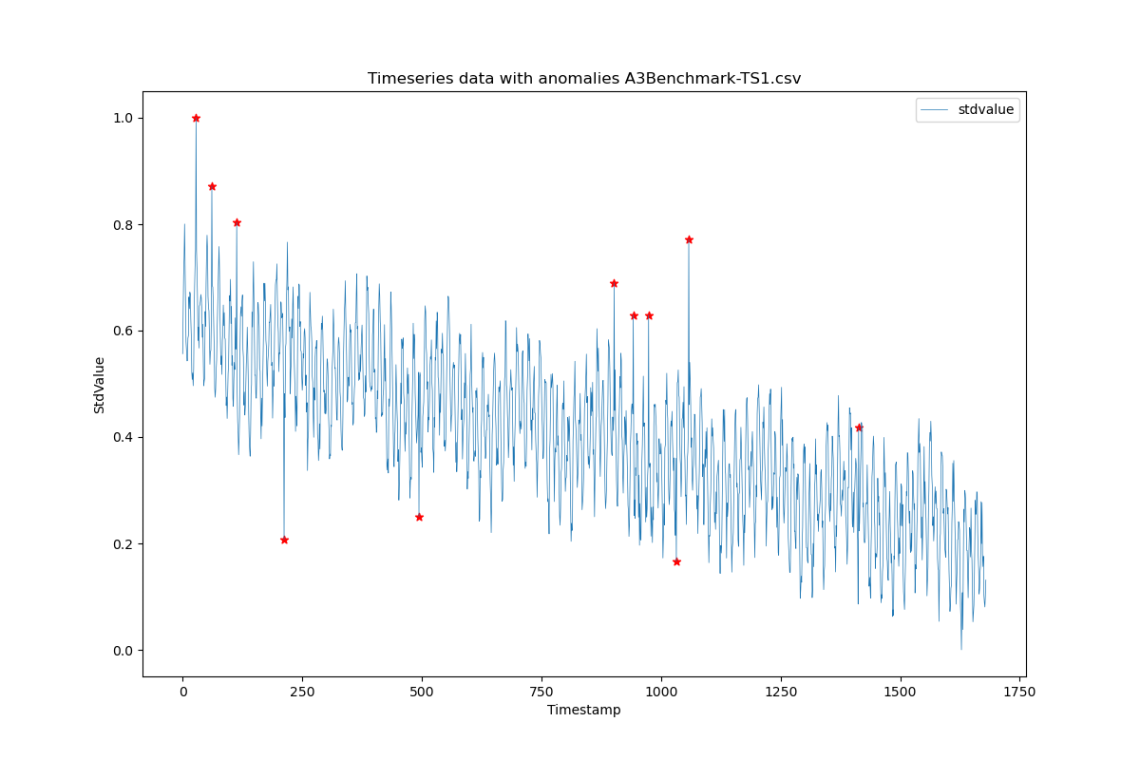

dtaianomaly A Python library for time series anomaly detection

Abstract

dtaianomaly is an open-source Python library for time series anomaly detection, designed to bridge the gap between academic research and real-world applications. Our goal is to (1) accelerate the development of novel state-of-the-art anomaly detection techniques through simple extensibility; (2) offer functionality for large-scale experimental validation; and thereby (3) bring cutting-edge research to business and industry through a standardized API, similar to scikit-learn to lower the entry barrier for both new and experienced users. Besides these key features, dtaianomaly offers (1) a broad range of built-in anomaly detectors, (2) support for time series preprocessing, (3) tools for visual analysis, (4) confidence prediction of anomaly scores, (5) runtime and memory profiling, (6) comprehensive documentation, and (7) cross-platform unit testing.

The source code of dtaianomaly, documentation, code examples and installation guides are publicly available at https://github.com/ML-KULeuven/dtaianomaly.

Keywords: Python, open source, time series, anomaly detection, data mining

-

DeepSeek教你如何学习人工智能

Thinking…

好的,用户现在需要一个人工智能的学习路线图。之前已经回答过类似的问题,但这次可能需要更详细的结构化内容,比如路线图的形式。用户可能希望看到分阶段、分模块的步骤,每个阶段的目标和关键知识点。

首先,我需要回顾之前的回答,确保这次的结构更加清晰,可能用时间线或阶段图来表示。用户可能没有明确的背景,所以需要保持通用性,适合不同起点的人。需要涵盖基础、机器学习、深度学习、实践项目、专业方向选择以及持续学习。

可能在之前的回复中已经分阶段了,但路线图可能需要更视觉化的层次,比如分基础、核心、高级等阶段,每个阶段包括时间估计、学习内容和目标。同时,用户可能关心每个阶段需要花费多长时间,所以添加时间参考会有帮助。

另外,用户可能需要一些学习技巧或资源推荐,比如推荐的书籍、在线课程、工具等。可能需要强调数学和编程的基础,因为这是很多初学者的难点,但要避免让用户感到畏难,可以建议他们边学边补基础。

还要考虑实践的重要性,每个阶段都应该有对应的项目或练习,帮助巩固知识。可能需要调整之前的项目建议,使之更符合路线图的阶段性目标,比如从简单的MNIST到复杂的Kaggle竞赛。

另外,专业方向的选择可能需要更详细的细分,比如计算机视觉、自然语言处理、强化学习等,每个方向需要哪些额外的技能和工具。用户可能希望了解不同方向的前景和学习路径。

需要注意避免信息过载,保持路线图的简洁性和可操作性。可能需要用列表或分点的方式,而不是大段文字,让用户容易跟随。同时,添加一些鼓励的话语,比如学习建议,保持动力。

最后,检查是否有遗漏的关键点,比如数据处理、模型部署、工具学习等,这些都是实际工作中需要的技能,应该包含在路线图中。还要确保资源是最新和常用的,比如Hugging Face库、PyTorch等。

以下是针对不同学习阶段的 人工智能学习路线图,涵盖从基础到进阶的关键路径,适合系统性学习:

阶段一:基础夯实(1-3个月)

目标:掌握编程、数学基础,了解AI核心概念

- 编程基础

- Python:语法、函数、面向对象编程(推荐《Python Crash Course》)。

- 数据处理:

NumPy(矩阵计算)、Pandas(数据清洗)、Matplotlib(可视化)。 - 工具:Jupyter Notebook、Git/GitHub。

- 数学基础

- 线性代数:矩阵运算、特征值分解(推荐3Blue1Brown视频)。

- 概率统计:概率分布、贝叶斯定理、假设检验。

- 微积分:导数、梯度、链式法则(理解反向传播的基础)。

- 入门AI概念

- 机器学习分类(监督/无监督/强化学习)。

- 简单算法实践:线性回归、KNN分类(用Scikit-Learn实现)。

阶段二:机器学习核心(3-6个月)

目标:深入经典算法,掌握模型构建与调优

- 经典算法学习

- 监督学习:逻辑回归、决策树、SVM、集成学习(随机森林、XGBoost)。

- 无监督学习:K均值聚类、PCA降维。

- 模型评估:交叉验证、ROC曲线、混淆矩阵、Bias-Variance Tradeoff。

- 工具与框架

- Scikit-Learn:全流程实现(数据预处理→建模→评估)。

- 实战项目:

- 房价预测(回归任务)、鸢尾花分类(分类任务)。

- Kaggle入门竞赛(如Titanic生存预测)。

- 数学深化

- 损失函数(交叉熵、MSE)、正则化(L1/L2)、梯度下降原理。

阶段三:深度学习进阶(6-12个月)

目标:掌握神经网络与主流框架,深入CV/NLP等领域

- 神经网络基础

- 感知机、多层感知机(MLP)、反向传播、激活函数(ReLU、Sigmoid)。

- 框架学习:

- PyTorch:动态图、自动微分(推荐官方教程)。

- TensorFlow:静态图、Keras高阶API。

- 核心领域技术

- 计算机视觉(CV):

- CNN(LeNet、ResNet)、目标检测(YOLO)、图像分割(U-Net)。

- 工具:OpenCV、MMDetection。

- 自然语言处理(NLP):

- 词嵌入(Word2Vec)、RNN/LSTM、Transformer、BERT/GPT。

- 工具:Hugging Face库、Spacy。

- 强化学习(RL):Q-Learning、Policy Gradient、OpenAI Gym环境。

- 实战项目

- CV:CIFAR-10图像分类、口罩检测。

- NLP:新闻分类、聊天机器人(Seq2Seq)。

- 部署:使用Flask/Docker部署模型到云端。

阶段四:专业方向深耕(1年以上)

目标:选择细分领域,参与科研或工业级项目

- 方向选择

- CV:3D视觉、GAN生成模型、视频理解。

- NLP:多模态模型、对话系统、知识图谱。

- RL:多智能体系统、机器人控制。

- AI与其他领域结合:医疗AI、自动驾驶、金融风控。

- 高阶技能

- 分布式训练(PyTorch DDP)、模型压缩(剪枝/量化)。

- 读顶会论文(NeurIPS/ICML/CVPR),复现SOTA模型。

- 开源贡献:参与GitHub项目(如PyTorch Lightning)。

- 职业发展

- 实习:加入AI Lab或大厂算法团队。

- 学术:攻读硕士/博士,发表论文。

- 创业:解决垂直领域问题(如AI+教育)。

工具与资源推荐

- 学习平台

- Coursera:吴恩达《深度学习专项课》、DeepLearning.AI。

- 极客时间:AI技术内参、机器学习40讲。

- 论文库:arXiv、Papers With Code。

- 社区与竞赛

- Kaggle:参加比赛学习代码思路。

- GitHub:关注Trending AI项目(如Stable Diffusion)。

- 知乎/Reddit:跟踪技术讨论。

- 书籍

- 《深度学习》(花书)、《机器学习实战》、《动手学深度学习》。

关键学习原则

- 代码驱动:先跑通代码,再理解理论。

- 问题导向:从实际场景出发(如“如何检测图像中的物体?”)。

- 持续输出:写技术博客、复现论文、分享GitHub项目。

- 关注前沿:订阅AI Newsletter(如The Batch)。

如果需要针对某个领域(如CV/NLP)的细化路线,可以进一步讨论! 🚀

-

机器学习十大算法

机器学习十大算法的 Python 代码示例,我们将使用常见的

scikit-learn库来实现,数据集使用鸢尾花数据集。1. 决策树算法(Decision Tree)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.tree import DecisionTreeClassifier from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建决策树分类器 clf = DecisionTreeClassifier() clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"决策树准确率: {accuracy}")2. 朴素贝叶斯算法(Naive Bayes)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.naive_bayes import GaussianNB from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建朴素贝叶斯分类器 clf = GaussianNB() clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"朴素贝叶斯准确率: {accuracy}")3. 支持向量机(Support Vector Machine,SVM)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.svm import SVC from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建 SVM 分类器 clf = SVC() clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"SVM 准确率: {accuracy}")4. K 近邻算法(K – Nearest Neighbor,KNN)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.neighbors import KNeighborsClassifier from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建 KNN 分类器 clf = KNeighborsClassifier() clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"KNN 准确率: {accuracy}")5. 逻辑回归(Logistic Regression)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.linear_model import LogisticRegression from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建逻辑回归分类器 clf = LogisticRegression(max_iter=1000) clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"逻辑回归准确率: {accuracy}")6. 随机森林算法(Random Forest)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.ensemble import RandomForestClassifier from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建随机森林分类器 clf = RandomForestClassifier() clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"随机森林准确率: {accuracy}")7. 梯度提升树(Gradient Boosting Decision Tree,GBDT)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.ensemble import GradientBoostingClassifier from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建 GBDT 分类器 clf = GradientBoostingClassifier() clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"GBDT 准确率: {accuracy}")8. K – 均值聚类算法(K – Means Clustering)

from sklearn.datasets import load_iris from sklearn.cluster import KMeans import matplotlib.pyplot as plt # 加载数据集 iris = load_iris() X = iris.data # 创建 KMeans 聚类器 kmeans = KMeans(n_clusters=3, random_state=42) kmeans.fit(X) # 获取聚类标签 labels = kmeans.labels_ # 可视化聚类结果(取前两个特征) plt.scatter(X[:, 0], X[:, 1], c=labels, cmap='viridis') centers = kmeans.cluster_centers_ plt.scatter(centers[:, 0], centers[:, 1], c='red', marker='X', s=200) plt.title('K - Means Clustering') plt.xlabel('Sepal length') plt.ylabel('Sepal width') plt.show()9. 主成分分析(Principal Component Analysis,PCA)

from sklearn.datasets import load_iris from sklearn.decomposition import PCA import matplotlib.pyplot as plt # 加载数据集 iris = load_iris() X = iris.data # 创建 PCA 对象,降维到 2 维 pca = PCA(n_components=2) X_pca = pca.fit_transform(X) # 可视化降维后的数据 plt.scatter(X_pca[:, 0], X_pca[:, 1], c=iris.target, cmap='viridis') plt.title('PCA of Iris Dataset') plt.xlabel('Principal Component 1') plt.ylabel('Principal Component 2') plt.show()10. AdaBoost 算法(Adaptive Boosting)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.ensemble import AdaBoostClassifier from sklearn.metrics import accuracy_score # 加载数据集 iris = load_iris() X = iris.data y = iris.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建 AdaBoost 分类器 clf = AdaBoostClassifier() clf.fit(X_train, y_train) # 预测 y_pred = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"AdaBoost 准确率: {accuracy}")这些代码示例展示了如何使用

scikit-learn库实现机器学习十大算法,并在鸢尾花数据集上进行简单的训练和测试。你可以根据实际需求调整参数和使用其他数据集。 -

K-Means 算法

K-Means 是一种无监督学习算法,用于将数据点划分为

k个不同的簇。下面是使用 PyTorch 实现 K-Means 算法的代码示例:import torch def kmeans(X, k, max_iter=100): """ K-Means 算法的 PyTorch 实现 参数: X (torch.Tensor): 输入数据,形状为 (n_samples, n_features) k (int): 簇的数量 max_iter (int): 最大迭代次数 返回: torch.Tensor: 每个数据点所属的簇的索引 torch.Tensor: 每个簇的中心点 """ # 随机初始化中心点 n_samples, n_features = X.shape indices = torch.randperm(n_samples)[:k] centroids = X[indices] for _ in range(max_iter): # 计算每个数据点到每个中心点的距离 distances = torch.cdist(X, centroids) # 找到每个数据点最近的中心点 labels = torch.argmin(distances, dim=1) # 更新中心点 new_centroids = torch.zeros(k, n_features, dtype=X.dtype, device=X.device) for i in range(k): cluster_points = X[labels == i] if len(cluster_points) > 0: new_centroids[i] = torch.mean(cluster_points, dim=0) else: # 如果某个簇为空,重新随机初始化该中心点 new_centroids[i] = X[torch.randint(0, n_samples, (1,))] # 判断是否收敛 if torch.allclose(centroids, new_centroids): break centroids = new_centroids return labels, centroids你可以使用以下方式调用这个函数:

# 生成一些示例数据 n_samples = 100 n_features = 2 X = torch.randn(n_samples, n_features) # 运行 K-Means 算法 k = 3 labels, centroids = kmeans(X, k) print("每个数据点所属的簇的索引:", labels) print("每个簇的中心点:", centroids)代码解释:

- 初始化中心点:从输入数据中随机选择

k个点作为初始中心点。 - 迭代更新:

- 计算每个数据点到每个中心点的距离。

- 找到每个数据点最近的中心点,并将其分配到该簇。

- 更新每个簇的中心点,即计算该簇中所有数据点的平均值。

- 收敛判断:如果中心点不再发生变化,则认为算法收敛,停止迭代。

注意事项:

- 该实现使用欧几里得距离来计算数据点之间的距离。

- 如果某个簇为空,我们重新随机初始化该簇的中心点,以避免出现中心点为零向量的情况。

- 初始化中心点:从输入数据中随机选择

-

KNN算法

K近邻(K-Nearest Neighbors,KNN)算法是一种基本的分类与回归方法。下面分别给出KNN分类和KNN回归的Python实例代码。

1. KNN分类实例

我们将使用

scikit-learn库中的鸢尾花数据集进行KNN分类。from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.neighbors import KNeighborsClassifier from sklearn.metrics import accuracy_score # 加载鸢尾花数据集 iris = load_iris() X = iris.data # 特征数据 y = iris.target # 标签数据 # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建KNN分类器,这里k值设为5 knn = KNeighborsClassifier(n_neighbors=5) # 训练模型 knn.fit(X_train, y_train) # 进行预测 y_pred = knn.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"KNN分类准确率: {accuracy}")代码解释:

- 数据加载:使用

load_iris函数加载鸢尾花数据集。 - 数据划分:使用

train_test_split函数将数据集划分为训练集和测试集,测试集占比为30%。 - 模型创建:使用

KNeighborsClassifier创建KNN分类器,n_neighbors参数指定K值为5。 - 模型训练:使用

fit方法对训练数据进行训练。 - 模型预测:使用

predict方法对测试数据进行预测。 - 准确率计算:使用

accuracy_score函数计算预测结果的准确率。

2. KNN回归实例

我们将使用

scikit-learn库中的波士顿房价数据集进行KNN回归。from sklearn.datasets import load_boston from sklearn.model_selection import train_test_split from sklearn.neighbors import KNeighborsRegressor from sklearn.metrics import mean_squared_error # 加载波士顿房价数据集 boston = load_boston() X = boston.data # 特征数据 y = boston.target # 标签数据 # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 创建KNN回归器,这里k值设为5 knn_reg = KNeighborsRegressor(n_neighbors=5) # 训练模型 knn_reg.fit(X_train, y_train) # 进行预测 y_pred = knn_reg.predict(X_test) # 计算均方误差 mse = mean_squared_error(y_test, y_pred) print(f"KNN回归均方误差: {mse}")代码解释:

- 数据加载:使用

load_boston函数加载波士顿房价数据集。 - 数据划分:使用

train_test_split函数将数据集划分为训练集和测试集,测试集占比为30%。 - 模型创建:使用

KNeighborsRegressor创建KNN回归器,n_neighbors参数指定K值为5。 - 模型训练:使用

fit方法对训练数据进行训练。 - 模型预测:使用

predict方法对测试数据进行预测。 - 均方误差计算:使用

mean_squared_error函数计算预测结果的均方误差。

需要注意的是,波士顿房价数据集在

scikit-learn1.2及以上版本中已被移除,如果你使用的是较新版本,可以使用fetch_california_housing数据集代替。 - 数据加载:使用